你好!欢迎来到北京图象图形学学会!

学会动态

更多>

- BSIG2023优秀硕士学位论文及优秀导师征集

- 在十届优秀博士论文评选的基础上,由北京图象图形学学会组织评选的优秀硕士论文及优秀导师奖,开始征集论文,希望学会理事和会员踊跃参加,欢迎近两年北京地区(含京、津、冀地区)的优秀硕士毕业生及导师参评:申请条件1.在攻读硕士学位期间,在图像图形学与技术及其相关领域的基础理论或应用研究中有重要理论或现实意义;有创新,有突破的成果,达到国内先进水平,具有较好的应用前景;内容充实,逻辑严谨,文字表达符合学术规范,内容不涉密,可在互联网上公开评审并全文公示。2.作者应为2022年3月1日至2024年7月15日内通过答辩的硕士论文。3.接受高校或科研院所推荐的候选论文,学会各会员单位或学会理事个人可直接推荐论文,原则上每家推荐单位推荐不超过2篇,每位理事推荐1篇。4.每年评选原则上优秀硕士论文不超过5篇,优秀论文提名不超过5篇;获奖论文作者的导师,同时获得优秀导师荣誉或优秀导师提名荣誉。5.申请者需为北京图象图形学学会会员。申请程序1.请将硕士论文报名表发送至以下邮箱:igta@bsig.org.cn,报名表请见文末“附件”。2.邮件注明:邮件附件为报名表+姓名。3.提交截止日:2024年7月21日,需注册参加IGTA2024会议交流,会议网址:http://www.igta.org.cn。4.非会员请首先在学会官网申请注册。注册网址:http://www.bsig.org.cn/member/reg证书及奖励1.向优秀硕士论文作者颁发证书、奖金,向优秀导师颁发证书。2.经获奖者许可,论文将会被推荐到北京市科协青年优秀科技论文奖、中国图象图形学学会等相关优秀论文评选。3.评选结果将于2023年8月6日前,在学会网站首页及学会微信公众号(参见下方)上公布。4.向获奖学生及导师发放相应的证书,证书将在第十九届图像图形技术与应用学术会议(IGTA2024)8月17日举办的开幕式环节颁发。5.学会将于IGTA2024会后举办北京图象图形学学会优秀硕士论坛,诚邀获得优秀硕士论文作者和优秀导师参加并进行学术报告,届时发放优秀硕士学位论文奖奖金。论坛举办的具体时间会在稍晚公布,请关注学会官网或微信公众号。 6.获奖优秀博士、硕士论文获得者,将会被优先推荐到其他市级,国家级相关评选,并优先参加学会其他项目交流。联系办法电话:010-82525258 邮箱:igta@bsig.org.cn学会网站:www.bsig.org.cn 学会咨询微信:严禁抄袭、剽窃等学术道德问题,如确认类似信息,北京图象图形学学会有权取消其参加资格,撤销证书并在官网上公布。优硕报名申请表(2024).docx

成果展示

更多>

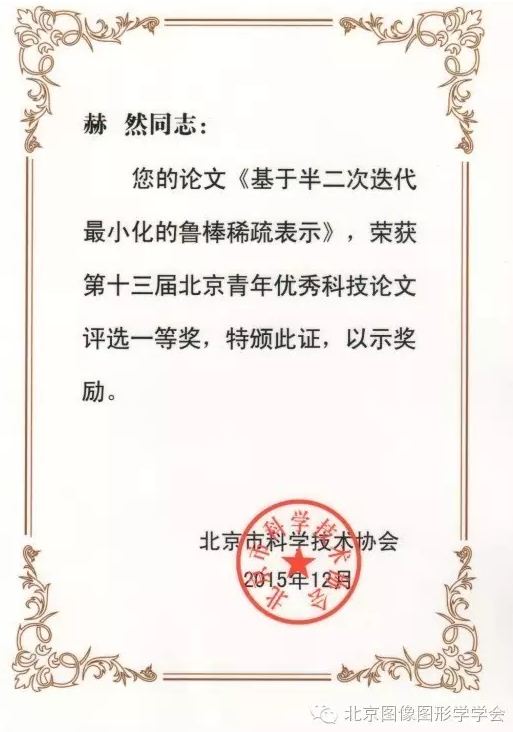

- 北京图象图形学学会2023年大事记

- 北京图象图形学学会在2022年的工作中,针对自身的特点,深入进行学术交流,积极通过学会的活动扩大学会的影响,严格遵守北京市科协及北京市民政局的各项规定,综合总结如下:学术交流研讨第十八届图像图形技术与应用学术会议(IGTA2023)由北京图象图形学学会主办、北京工业大学承办的第十八届图像图形技术与应用学术会议(IGTA2023)于8月17日-19日在北京友谊宾馆召开。大会吸引了两百余位专家学者参会。大会收到有效投稿论文129篇,通过3轮审稿,录用中英文论文47篇,其中,39篇英文论文正在通过Springer出版并提交EI检索,论文集已连续十一年通过Springer出版,并EI检索。汇聚科技“她”力量论坛(2023年第一期)3月8日,由学会女工委和IEEE WIE北京分会联合主办的汇聚科技“她”力量论坛,以线上腾讯会议和蔻享学术以及IEEE官方视频号平台进行网络直播,吸引了近千人观看。通过本次论坛,进一步增强领域女性科技工作者之间的互信和交流,营造更多的平台和机会,让社会更加关注女性科技工作者在科学事业当中的作用和成果。“AI大模型路在何方”讨论会4月7日,由学会青工委和女工委联合主办的 “AI大模型路在何方” 讨论会在北京达园宾馆成功召开。学会组织展开小范围深度对话式研讨,希望从交流中获得灵感,引领科研工作顺应社会热点需求,提供强势技术支撑。青年人才成长论坛(第四期)5月4日,由学会主办,青工委承办的《北京图象图形学学会青年学者交流论坛暨新委员招募会》以线上线下相结合的形式召开,交流中分享的经验引起青年学者的广泛兴趣。2023 IEEE WIE 女工程师领导力论坛10月21日,学会协办的第五届IEEE WIE女工程师领导力论坛(IEEE WIE CLS)在上海召开,众多杰出女性汇聚一堂,共同探讨女性领导力提升与未来发展,现场来宾和参会人员包括工程师、研究员、创新者以及业界领袖等超300人。通过本次论坛向世界展示了首都图像图形女性科技工作者的领导才能、工作才干和奋斗激情。汇聚科技“她”力量论坛(2023年第二期)11月11日上午,北京图象图形学学会2023年度女科技工作者年度学术论坛在中关村国际创新大厦3层会议室成功举办。此次活动由学会女工委和IEEE WIE北京分会联合主办。论坛充分展示了女性在科技领域中的不懈努力和卓越表现。青年人才成长论坛(第五期)12月5日,学会青工委和中国科学院自动化研究所联合承办的“BSIG-青年学者成长论坛(第五期)与《中国图象图形学报研究生论坛》于北京中国科学院自动化所召开,线上线下共吸引五千余人参加。汇集首都青年人才,探讨如何共同促进人工智能发展及本领域青年人才培养。组织建设和内部治理三十周年庆典北京图象图形学学会三十周年庆典于8月18日在北京友谊宾馆隆重召开。北京市科协、学会理事、会员、专家学者共220余人出席了本次庆典。学会成立三十年,砥砺奋进三十载,扬帆起航念初心。在历届理事们的帮助下,学会自1993年9月20日创立,逐步成长为图象图形领域内具有一定影响力的5A级科技社团。学会也将继续以加强组织建设、提升服务能力、促进学科发展为目标,以服务图像图形科技工作者为根本,团结广大科技工作者,把握时代发展机遇,齐心协力、砥砺前行,不断开拓学会工作新局面。愿我们共同努力,迎接下一个充满希望的三十年。党建活动作为一家积极响应党的号召的社会组织,学会在2023年高度重视党建工作。我们组织了党员学习交流会、主题党日活动等,加强了党员的思想政治教育和党性修养。同时,我们还积极参与党组织的各项活动,为党的事业贡献力量,展现了学会的良好形象。工作委员会青年科技工作者委员会青年人才是学会发展的动力源泉,为了更加广泛地汇聚图像图形领域的青年学者,一方面为其提供一个交流合作的平台,另一方面为学会未来储备管理人才,学会青工委,在已有委员的基础上,公开增选新的委员,吸引了27位优秀青年学者加入学会。女科技工作者委员会学会女工委旨在团结和组织广大女科技工作者,开展图像图形学领域的专业技术活动,继承和发扬女科学家精神,促进本领域女科技工作者之间的学术交流与产学研合作,承担知识普及、建言献策等社会服务工作为提升图像图形及相关领域的科研、教学、应用水平以及国际影响力做出贡献。同时,委员会将引领联系服务广大女科技工作者在实现科技自立自强中拼搏奋斗,为广大女科技工作者提供宝贵的学习和发展机会。学会女工委今年共进行了两次纳新活动,共吸引34位优秀女科技工作者加入学会。人才培育激励第十七届北京青年优秀科技论文征集学会按照《关于开展第十七届北京青年优秀科技论文征集的通知》的精神,按照公开、公平、公正的原则,严格标准,严格程序、严格审核,保证推荐工作的公正性和透明性。在此基础上,学会从征集到51篇优秀青年科技论文中遴选出14篇优秀论文上报科协。优秀博士、硕士论文奖和优秀导师奖的评选工作学会在今年继续开展优秀博士、硕士论文奖和优秀导师奖的评选工作,本次评选共遴选出5篇优秀博士论文奖、5位优秀博士导师奖以及6篇优秀博士论文提名奖和6位优秀博士导师提名奖,2篇优秀硕士论文奖、2位优秀硕士导师奖以及3篇优秀硕士论文提名奖和3位优秀硕士导师提名奖。评奖范围辐射到北京周边的京津冀地区。2024-2026年度青年人才托举工程被托举人遴选工作根据《北京市科协青年人才托举工程管理办法》《北京市科学技术协会关于开展2024-2026年度青年人才托举工程被托举人遴选工作的通知》有关要求,学会组织开展北京市科协2024-2026年度青年人才托举工程项目的评选工作,本次项目北京学会有8名托举名额(含5名自筹名额)。 北京图象图形学学会“最美女科技工作者” 遴选工作学会为了更好的发挥科研创新中的女性力量,鼓励更多女性进入科研领域成为高层次科研人才,有力地推动科学技术的创新、进步和发展,学会今年继续开展本领域的“最美女科技工作者”遴选工作。决策咨询建议《虚拟现实产品设计师国家职业技能标准》开发6月27日,《虚拟现实产品设计师国家职业技能标准》开发启动会,在江西南昌“江西国际人才港”成功召开,来自高校、企业的29家参标单位的专家代表就标准编写工作进行了充分交流。12月5日,虚拟现实产品设计师国家职业标准初审会在北京召开。受人力资源和社会保障部职业能力建设司委托,北京图象图形学学会承担虚拟现实产品设计师国家职业标准开发工作。来自虚拟现实领域学术界、产业界的10余位专家学者就职业标准开发的具体工作进行了研讨交流。北京人工智能产业与图像图形技术融合发展决策咨询沙龙8月18日,由北京市科学技术协会主办,学会承办的“北京人工智能产业与图像图形技术融合发展”决策咨询沙龙在北京友谊宾馆召开。为北京市人工智能产业发展提供帮助。推动成果转化、带动创新创业发展,引导专业人才更好的实现优化就业。北京市灵境计划职业标准起草工作为推动人工智能赋能元宇宙,推进元宇宙关键技术在智慧城市、影视娱乐、数字创意等领域的创新应用,加快集聚和培养灵境(虚拟现实)工程技术人才,助力全国科技创新中心建设和新职业新专业发展,学会参与了《北京市工程技术系列灵境(虚拟现实)专业职称评价试行办法》的编写工作,为北京的国际科技创新建设,为人才高地建设做出贡献。科学传播数字媒体技术国画艺术演示学会通过举办数字艺术展览展示、数字艺术产品路演活动,面向公众,展示不一样的画笔,弘扬中国传统艺术的同时,推广数字技术应用。本项目不仅面对向青少年受众,凡是热爱中国传统艺术的爱好者,均可通过现代数字技术,实现艺术梦想。第十三届亚太地区大学生数学建模竞赛2023年第十三届亚太地区大学生数学建模竞赛是学会主办的亚太地区大学生学科类竞赛,竞赛设置等级奖和优秀组织奖、优秀指导教师奖。本次竞赛共有969所高校2万7千多名学生报名参赛。数字化转型和数字科协应用学会日常工作有赖于科协数字平台的支持,“数字科协”的建设加强了科协与学会及科技工作者的广泛联系,提升服务科技工作者的质量水平。2024北京图象图形学学会BSIG

学术会议

更多>

- 第四届亚洲触觉会议(Asiahaptics2022)在京成功举办

- 2022年11月12日至14日,第四届亚洲触觉会议AsiaHaptics2022在北京市友谊宾馆成功举办。AsiaHaptics是触觉领域的四大国际会议之一,是以交互式演示为特色的触觉国际学术会议,自创办以来首次在中国举办。本次会议由北京航空航天大学、北京图象图形学学会、IEEE触觉技术委员会、IEEE计算机学会、日本虚拟现实学会联合主办,旨在展示国内外触觉领域的最新研究成果,为触觉领域同仁提供国际交流的平台。为有效应对新冠疫情对于国际学术交流的挑战,本次会议采取“一主三副同步、线上线下联动”的组织和参会形式,在中国北京设立主会场,在中国南京、日本东京、韩国大田分别设立分会场。来自中国北京主会场的信号向全球直播,面向全球线上观众免费开放,创新突破了地域限制,服务相关领域学者尽享学术交流。本次大会由北京航空航天大学王党校教授、东南大学宋爱国教授共同担任大会主席,得到了世界各地的触觉领域各学术组织、研究学者和工业界同仁的广泛关注和支持。会议由北航虚拟现实技术与系统全国重点实验室和北航机械工程及自动化学院承办,由中国计算机学会人机交互专业委员会和虚拟现实与可视化技术专业委员会协办。浓郁秋色中,来自清华大学、北京大学、北京航空航天大学、东南大学、厦门大学、大连理工大学、中科院软件研究所、之江实验室等全国各地高校和研究机构的触觉领域学者汇聚主会场,来自日本、韩国、美国、意大利、德国、俄罗斯、阿联酋、瑞士、中国香港等国家和地区的权威专家、研究学者、工程技术人员和企业代表通过线上线下结合的方式参加了本次会议,共同推进触觉领域的学术研究和产业应用,向全球展示触觉领域中国学者的成果和贡献。在大会开幕式上,中国工程院院士、北京航空航天大学赵沁平教授,北京图象图形学学会理事长、北京理工大学王涌天教授,AsiaHaptics会议创始人、日本筑波大学Hiroo Iwata教授和韩国KAIST大学Dong-Soo Kwon教授等国内外专家发表致辞,表达了对本次大会成功召开的祝贺和对近年来中国触觉领域研究成果的充分肯定。2中国工程院院士赵沁平教授致辞3北京图象图形学学会理事长王涌天教授致辞4日本筑波大学Hiroo Iwata教授致辞5韩国KAIST大学Dong-Soo Kwon教授致辞会议邀请了中国科学院院士、北京纳米能源与系统研究所王中林教授,IEEE Fellow、美国普渡大学Hong Z. Tan教授和IEEE Fellow,IEEE Transactions on Haptics主编、意大利锡耶纳大学Domenico Prattichizzo教授作主题报告。王中林院士介绍了摩擦电纳米技术的基本理论、关键技术以及在自供电电触觉交互系统中的应用,如物联网、环境监测、人机交互等,将有力赋能未来触觉技术。6中国科学院院士王中林教授作主题报告普渡大学Hong Z. Tan教授分享了设计触觉符号的独到见解,介绍了一种用于传递文本信息的触觉交流系统,提供了使用信息理论框架实现在皮肤上传输符号的设计准则和实现方法,展示了使用触觉显示系统传输信息的可能性,为基于触觉模态的通讯和协作研究提供了启发。7美国普渡大学Hong Z. Tan教授作主题报告Domenico Prattichizzo教授介绍了可穿戴触觉技术面临的挑战性难题,针对两种新的应用提出了创新性解决思路。结合机器人技术和触觉设备,推动交互的边界从扩展现实到物理环境,并通过穿戴式人机界面同时控制人类和机器肢体,提高用户在协作中的控制准确性和参与度,表现出触觉技术在未来元宇宙时代的巨大应用前景。8意大利锡耶纳大学Domenico Prattichizzo教授作主题报告会议设立三场新锐技术分享论坛,14场学术、技术报告,针对触觉技术与机器人的融合、元宇宙的应用以及工业用途三个研究方向,报告人覆盖学界知名学者和业界主要公司。会议邀请东南大学宋爱国教授、清华大学孙富春教授、清华大学徐迎庆教授、中科院自动化研究所侯增广研究员、吉林大学孙晓颖教授、中科院软件研究所田丰研究员、香港城市大学于欣格教授、韩国KAIST Jee-Hwan Ryu教授、韩国庆熙大学Seokhee Jeon教授等中外学者和Barrett Technology、Force Dimension 、埃斯顿医疗、数字栩生、飞宇星电子等触觉领域相关国内外企业的代表进行精彩报告。9清华大学孙富春教授作报告10清华大学徐迎庆教授作报告11中科院软件研究所田丰研究员作报告12国内外学者线上报告(6合一)作为AsiaHaptics会议的传承亮点,本次会议以灵动的现场演示、论文海报展示、快闪式报告等多种形式展示了39项触觉尖端研究。尤其是本次会议的特色——交互式演示环节,现场提供了穿戴式、屏幕式等各类触觉技术体验;展示了触觉在教育、文旅、医学、养老助残等多领域在内的发展前景,集视、听、触、感等多模态体验为一体,提供虚实融合的全新体验。现场交互式演示的形式,为参会者提供了亲身体验最新触觉交互硬件及多模态交互系统的平台,加强了开发者及体验者的现场沟通交流,吸引了众多专家学者和参会者通过实际操作体验中,体会了虚拟触觉的美妙,线上线下频频点赞。13-16参会者体验触觉交互系统及现场交流与此同时,在中国南京、日本东京和韩国大田分会场,各地参会学者聆听主会场报告并进行在线学术交流。日本东京分会场,超过100名日本学者参加会议,超过30项触觉相关研究在现场进行交互式展示和体验。韩国大田分会场,近100名学者参加,十余项触觉相关研究也在同时进行现场与网络的交互式展示和体验。17中国南京分会场18日本东京分会场19韩国大田分会场本次大会共有来自中国、日本、韩国、德国、俄罗斯、阿联酋等多个国家的46篇论文和77项展示投稿,最终17篇论文和39项展示被大会录用。投稿经过组委会评选,来自俄罗斯Skolkovo科学技术研究院团队的论文DeltaFinger: a 3-DoF wearable haptic display enabling high-fidelity force vector presentation at a user finger获得本届大会最佳论文奖,来自清华大学等高校的3个团队获得最佳论文提名奖。来自北京航空航天大学团队的展示Social companionship and diagnosis system for children with autism: a VR system with force and temperature feedback获得最佳展示奖,来自北京大学等高校的5个团队获得最佳展示提名奖,完整获奖名单可查阅会议官网。在大会闭幕式现场,组委会成员北京大学陈立翰副教授和大连理工大学刘倩副教授为获奖团队颁奖。20组委会成员陈立翰副教授为最佳论文颁奖21组委会成员刘倩副教授为最佳展示颁奖在元宇宙技术快速发展之际,AsiaHaptics 2022备受触觉、人机交互、虚拟现实、机器人技术等学术界和产业界的关注,全球万余观看了大会直播。大会吸引了华为终端有限公司、瑞士Force Dimension、埃斯顿医疗、红京鸟力维、夏貘科技、众绘虚拟现实、联博智业科技、飞宇星电子、诺亦腾科技等相关企业赞助及参加工业展示,促进触觉领域的学术成果的深度转化应用。本次会议通过线上线下一体联动的形式,为新冠肺炎疫情背景下召开国际学术会议,开展国际学术交流探索了新风格和新方法。22-23企业展览参观体验 当今世界进入了人机物三元融合的时代,AsiaHaptics 2022的胜利召开将有力推动中国触觉领域的发展,通过与亚太及全球的交流,展现了触觉领域的中国声音和中国力量。为我国触觉领域立足世界科技前沿,在虚拟现实、人机交互和机器人等领域的研究和应用注入创新活力;在新冠疫情背景下,为触觉技术走进千家万户,面向人民生命健康,服务医疗、教育、养老等国民经济主战场提供有力支撑;推动我国触觉领域的研究和发展紧贴国家战略需求,为建设世界科技强国做出更大贡献。 更多关于AsiaHaptics 2022的信息请前往http://www.asiahaptics2022.com/ AsiaHaptics 2022会议全程直播提供回放服务,供广大同仁回顾学习,回放视频请查看https://www.koushare.com/topicIndex/i/asiahaptics2022

- 显著性检测 背景吸收的马尔可夫显著性目标检测

- 显著性目标检测能够减少后续视觉任务的数据处理量,当目标的形状轮廓或色彩纹理组成复杂时,准确地检测出完整的显著性目标是一项具有挑战性的工作。专家推荐本文提出了一种背景吸收的马尔可夫显著性目标检测方法,能够克服原有方法在吸收节点选择、结果等方面的缺陷,在3个不同类型的公开数据集上与多种现有方法的比较实验表明,整体上本文方法在PR曲线、F值以及视觉效果上均有明显的优势。论文亮点1、将原始图象分割成不同数量的超像素块并筛选出合适的边界,分别基于边界节点吸收和背景节点吸收计算获得显著图,能够适应复杂场景得到鲁棒的结果。 2、提出了一种基于边界选择、背景节点选择的多层图融合模型,使得最终获得的显著图具有更好的显著性表达能力。论文方法在SLIC分割的基础上,首先通过差异化筛选去除差异较大的边界,选择剩余三条边界上的节点进行复制作为马尔可夫链的吸收节点,通过计算转移节点的吸收时间获得初始的显著图,然后从初始显著图中选择背景可能性较大的节点进行复制作为吸收节点,再进行一次重吸收计算获得显著图,并对来自不同数量超像素块分割结果导出的多层显著图进行融合获得最终的显著图。图1 本文方法的流程图实验结果实验在ASD、DUT-OMRON和SED3个数据集上,对比了现有的12种方法。ASD数据集包含1 000幅自然图像;DUT-OMRON数据集中有5168幅具有复杂背景且显著目标大小不一的图片;SED数据集中有200幅具有挑战性的图像。设置初始的边界选择时的参数超像素个数为m=250,获取背景吸收节点时的阈值t=0.015。 图2显示了多种方法在ASD数据集上的PR曲线和F值结果。图3和图4是在DUT-OMRON数据集和SED数据集进行对比的结果。从PR 曲线和F值结果可以看出,在ASD和DUT-OMRON数据集上,PR曲线和F值均是最高的,SED数据集中,PR曲线是最好的,F值略低于MC方法,但整体而言,本文算法优于其他12种现有的算法。 在图5中给出在3种不同的数据集上,各种算法的视觉比较,从图5可以看出本文的显著图结果在视觉效果上能够更好地突出整个目标,从直观上来看,本文算法优于其他12种算法。 图2 多种算法在ASD数据集上PR曲线与F值比较 图3 多种算法在DUT-OMRON数据集上PR曲线与F值比较 图4 多种算法在SED数据集上PR曲线与F值比较 图5 在3种数据库上不同方法的视觉比较 第一作者 蒋峰岭,现为中国科学技术大学模式识别与智能系统专业博士研究生,目前主要研究方向为计算机视觉。邮箱:fljiang@mail.ustc.edu.cn 通信作者 孔斌,研究员,博士生导师。中科院合肥智能机械研究所仿生视觉实验室负责人。任中国图象图形学学会理事,中国人工智能学会智能机器人专业委员会委员,安徽省人工智能学会理事。多年来一直从事图象处理、计算机视觉相关的研究工作,获中科院科技进步二等奖一项,发表论文40余篇,EI收录30多篇,申请国家发明专利10项。先后参加和承担国家攻关、国家自然科学基金、国家863、973等以及中科院下达和地方委托的科研项目二十多项。目前,主要研究方向为智能机器人环境感知、工农业机器视觉应用、仿生计算机视觉等。邮箱:bkong@iim.ac.cn.INTRODUCTION实验室介绍中国科学院合肥智能机械研究所是中国科学院合肥物质科学研究院的重要研究单元之一,致力于在仿生感知、信息获取、智能农业信息系统、智能检测与控制、微纳米技术、先进制造、安全系统等重要领域为国家做出基础性、战略性和前瞻性的研究和贡献。建所近四十年来,智能所先后承担了国家自然科学基金、“863”计划、“973”计划、国际科技合作计划、中科院、省部及地方科技攻关等课题近千项,取得了一大批重要科技成果,获得了国家科学技术进步二等奖、联合国世界信息峰会大奖、安徽省科技进步一等奖等100多项科技奖,并承办中国自动化学会核心学术期刊《模式识别与人工智能》。作者所在研究团队主要研究方向为智能机器人环境感知、工农业机器视觉应用、仿生计算机视觉等。近年来参加国家自然科学基金重大研究计划重点项目和集成项目、中国科学院战略性先导科技专项课题等的研究,参与研制的“智能先锋号”无人车在国家自然科学基金委员会主办的“中国智能车未来挑战赛”多次获得优秀成绩。 引用格式Jiang F L, Zhang H T, Yang J, Kong B . Image saliency detection based on background-absorbing Markov chain[J]. Journal of Image and Graphics, 2018, 23(6): 857-865. [蒋峰岭, 张海涛, 杨静, 孔斌. 背景吸收的马尔可夫显著性目标检测[J]. 中国图象图形学报, 2018, 23(6): 857-865.]DOI: 10.11834/jig.170492原文链接http://www.cjig.cn/html/jig/2018/6/weixin/20180608.htm近年国内外优秀的视觉显著性检测算法1、Itti等人[1]提出基于Koch生物识别框架,提取了多尺度的亮度、颜色、方向特征,采用中央周边差操作构造特征图,再将特征整合后突出显著性区域;2、Harel等人[2]提出了一种基于图的视觉显著性检测模型;3、Hou等人[3]提出了一个频谱残差模型(SR方法)来计算显著性;4、Jiang等人[4]提出的基于马尔可夫链的方法(MC方法)中,关注节点在马尔可夫链上的随机游走过程,根据转移节点到吸收节点的吸收时间的不同,获得超像素块的显著值;5、Qin等人[5]提出了基于元胞自动机的方法;6、Tu等人[6]引入最小生成树的方法,可以获得一个实时显著性检测方法。[1] Itti L, Koch C, Niebur E. A model of saliency-based visual attention for rapid scene analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20(11): 1254–1259. [DOI:10.1109/34.730558][2] Harel J, Koch C, Perona P. Graph-based visual saliency[C]//Proceedings of the 19th International Conference on Neural Information Processing Systems. Kitakyushu, Japan: ACM, 2006: 545-552. [DOI:10.1.1.70.2254][3] Hou X D, Zhang L Q. Saliency detection: a spectral residual approach[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis, Minnesota, USA: IEEE, 2007: 1-8. [DOI:10.1109/CVPR.2007.383267][4] Jiang B W, Zhang L H, Lu H C, et al. Saliency detection via absorbing Markov chain[C]//Proceedings of IEEE International Conference on Computer Vision. Sydney, NSW, Australia: IEEE, 2013: 1665-1672. [DOI:10.1109/ICCV.2013.209][5] Qin Y, Lu H C, Xu Y Q, et al. Saliency detection via cellular automata[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA: IEEE, 2015: 110-119. [DOI:10.1109/CVPR.2015.7298606][6] Tu W C, He S F, Yang Q X, et al. Real-time salient object detection with a minimum spanning tree[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA: IEEE, 2016: 2334-2342. [DOI:10.1109/CVPR.2016.256]

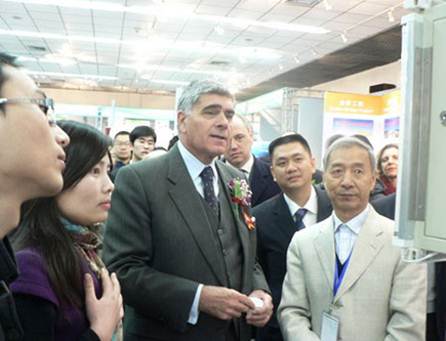

- 2014年全国科普日北京主场活动报道

- 2014年全国科普日北京主场活动,以“创新引领未来、创新改变生活、创新在我身边、创新圆我梦想”四个主题为主线,每个活动区有若干科普展项、展品和活动 ,为公众营造全新的科普体验。 中共中央政治局常委、中央书记处书记刘云山和刘奇葆、李源潮、郭金龙、韩启德等领导同志参加了20日上午在中国科技馆举行的全国科普日北京主场活动。 北京服装学院教师负责的《体感3D服饰文化展示平台》,《旗袍三维交互学习系统》,《budiu的智能定位童鞋》项目经过北京市科协的层层选拔,进入创新改变生活之居家生活展区。 参观活动结束时,刘云山指出实现“两个一百年”奋斗目标和中华民族伟大复兴的中国梦,需要以科技实力为支撑,以自主创新为动力。创新成就梦想,创新引领未来。要大力实施创新驱动发展战略,推动我国科技创新不断迈出新步伐、取得新成绩。希望中国科协和各级科协组织加强科普宣传,突出大众性、贴近性,让科技走进百姓、走进生活,让人们在参与中感受科技魅力、焕发创新动力。希望广大科技工作者、教育工作者发挥自身优势,肩负起倡导科学思想、传播科学知识的责任,引导全社会特别是青少年爱科学、学科学、用科学。各级党委和政府要把科普工作摆在重要位置,支持开展科普宣传,引导人们提高科学素质,投身建设创新型国家的生动实践。 今年全国科普日活动主题是“创新发展,全民行动”。围绕这一主题,各地将组织开展7700多项科普活动。北京的主场活动于9月20日至26日在中国科技馆举办。

- 千人进千企之—北京大模型技术研讨会第一期圆满成功

- 本次研讨会由北京市科学技术协会创新服务中心指导,由北京七月在线、中关村数智人工智能产业联盟联合主办,由北京图象图形学学会、北京秒如科技协办。于2023年11月19日,在中关村虚拟现实产业园A座成功举办,各行各业开发者、业务负责人、CEO等齐聚一堂,共同探讨大模型技术的发展,场景,经验,前沿等。分享人July分享人刘老师分享人石老师 3个小时的研讨会,4位嘉宾不遗余力地做了大模型技术分享,现场答疑,赢得了与会人员的一致好评! 随后4位分享人进行了现场答疑,对大模型技术、应用、发展等进行了深入的探讨和交流,为个人职业规划、大模型行业的发展找到了更明确的前进方向。 本次研讨会得到了北京市科学技术协会创新服务中心、中关村数智人工智能产业联盟联合、北京图象图形学学会、北京秒如科技的大力支持,是活动能够圆满成功的关键。论坛现场 同时,感谢参与者为获取新知不断努力的热情,你们的积极参与和鼎力支持为研讨会增添了无限活力。我们相信,每个心之所向的我们会为推动大模型的发展做出更大的贡献,共同推动行业的发展。本学会小店开业,敬请光临,扫描下方二维码了解更多:

推荐出版物

更多>

精品赏析

联系我们

- 电话010-82525258

- 邮箱office@bsig.org.cn